[3줄 AutoML] 언제까지 ReLU에 만족할래?

2021. 7. 7. 23:06ㆍAI Paper Review/AutoML Papers

<arxiv> https://arxiv.org/abs/1710.05941

Searching for Activation Functions

The choice of activation functions in deep networks has a significant effect on the training dynamics and task performance. Currently, the most successful and widely-used activation function is the Rectified Linear Unit (ReLU). Although various hand-design

arxiv.org

1. 그래, 렐루 좋은데 언제까지 렐루에만 안주할래? 우리는 오토매틱 서치로 새로운 액티베이션 펑션 만들거야!

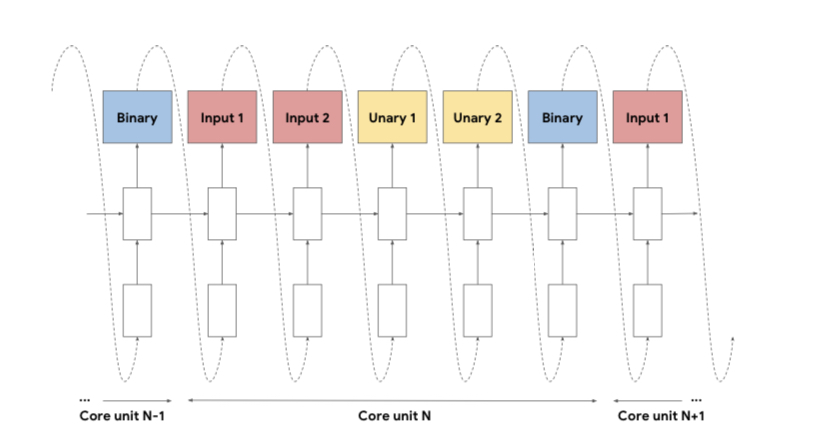

2. NAS에서 했던 것처럼 강화학습+RNN 컨트롤러 이용해서 찾아야지, 근데 서치 스페이스 줄이려면 어느정도의 activation function 구조를 정해둠으로써 inductive bias를 가미하는 게 좋을 것 같아.

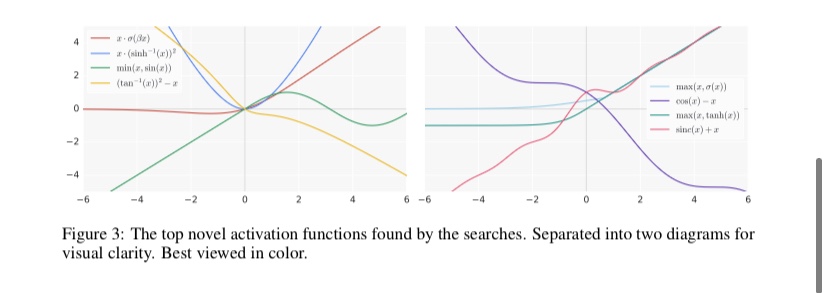

3. 많은 태스크에서 제너럴하게 잘 되는 활성화 함수 Swish가 탄생했다! 그것도 중요하지만, 대개 간단한 활성화 함수들이 잘 동작한다는 등 Search 과정에서 얻은 인사이트도 되게 많다!

'AI Paper Review > AutoML Papers' 카테고리의 다른 글

| [3줄 AutoML] 모든 사람을 면접할 수 없고, 모든 모델을 학습할 수 없다. (0) | 2021.07.12 |

|---|---|

| [3줄 AutoML] 솔직히 까놓고 말해서 기존 NAS 비효율적이지 않냐? (3) | 2021.07.09 |

| [3줄 AutoML] 옵티마이저도 한번 찾아볼까? (1) | 2021.07.07 |

| [3줄 AutoML] NAS with RL: 그 원대한 시작 (0) | 2021.07.07 |

| LHOPT: A Generalizable Approach to Learning Optimizers (0) | 2021.06.06 |