[3줄 AutoML] 솔직히 까놓고 말해서 기존 NAS 비효율적이지 않냐?

2021. 7. 9. 23:24ㆍAI Paper Review/AutoML Papers

<ECCV 2018> https://openaccess.thecvf.com/content_ECCV_2018/papers/Chenxi_Liu_Progressive_Neural_Architecture_ECCV_2018_paper.pdf

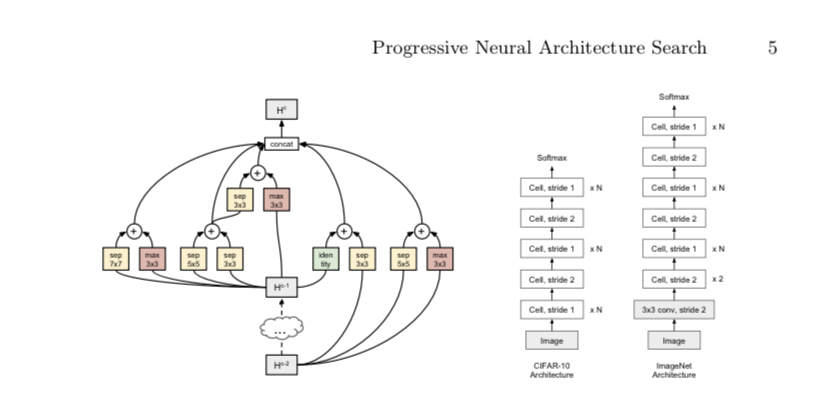

1. 기존 NAS는 무거운 RNN 셀과 RL을 사용하여 모델을 매번 처음부터 만들고 재학습시켜야 해서 되게 무겁고 비효율적이었다.

2. 그럼 재학습을 안 시키기 위해서 그냥 모델의 퍼포먼스를 프리딕션하는 모델을 만들고, 매번 만들지 말고 붙였다 뗐다 발전시켜나가는 방향의 NAS 시스템을 만들면 어떨까?

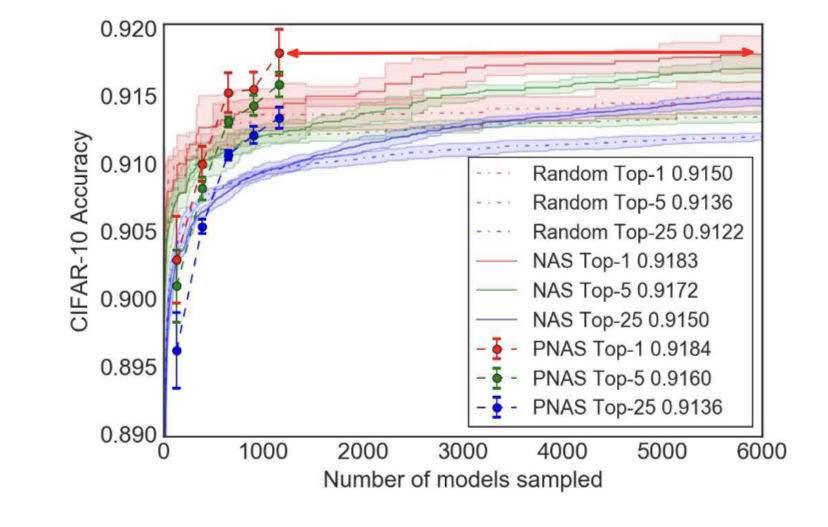

3. 기존 Zoph et al의 NAS보다 5배정도 빠른데다가, 아키텍쳐 성능도 정말 좋다!

'AI Paper Review > AutoML Papers' 카테고리의 다른 글

| [3줄 AutoML] AMC, 미국 작전주가 아니라 뉴럴넷 컴프레서! (0) | 2021.07.12 |

|---|---|

| [3줄 AutoML] 모든 사람을 면접할 수 없고, 모든 모델을 학습할 수 없다. (0) | 2021.07.12 |

| [3줄 AutoML] 옵티마이저도 한번 찾아볼까? (1) | 2021.07.07 |

| [3줄 AutoML] 언제까지 ReLU에 만족할래? (0) | 2021.07.07 |

| [3줄 AutoML] NAS with RL: 그 원대한 시작 (0) | 2021.07.07 |