2021. 7. 28. 22:29ㆍAI Paper Review/Deep RL Papers [EN]

<openreview> https://openreview.net/pdf?id=AY8zfZm0tDd

1. 모델 베이스드 방법론들 최근에 되게 좋은 sample efficiency 보여줬는데, 우리는 모델 프리로 기존 모델 베이스드 방법들 이겨보겠다. 또한 자원도 덜 쓰는 모델을 만들겠다!

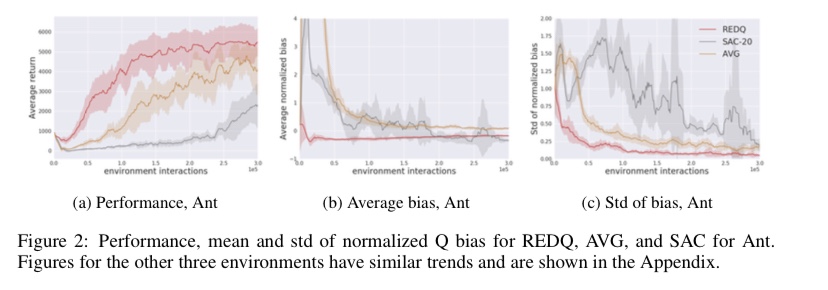

2. Sample Efficient 하다는건 데이터를 잘 쓴다는 뜻이므로 Update-To-Data Ratio를 올린 알고리즘을 만들어야지? 근데 그럼 다른 알고리즘도 UTD ratio 올리면 잘 되는거 아니냐는 반문이 있을 수 있다.

3. 그렇지만 SAC 같은 알고리즘은 UTD ratio를 너무 많이 쓰면 당연하게도 bias와 그 표준편차가 매우 커져 불안정하게 된다. 이것을 해결하기 위해 ensemble 방법론과 in-target minimization을 도입해 매우 안정적이면서 높은 성능의 학습이 가능하게 되었다.

4. 일전에 소개했던 maxmin q learning(bellman.tistory.com/44)과 비슷한 문제를 해결하는데 여기선 ensemble이 추가된 느낌이다. 기존 머신러닝 방법론들은 ensemble 잘 써서 성능 팍팍 올렸는데, 왜 강화학습은 이제서야 그런 논문이 나오는 걸까?

아무튼 q-learning에 ensemble을 사용하는 방법은 매우 좋아 보이고, 앞으로 policy를 잘 ensemble 하는 쪽의 논문른 없는지 찾아보아야겠다.

'AI Paper Review > Deep RL Papers [EN]' 카테고리의 다른 글

| [3줄 RL] RL + Contrastive = sample efficiency (0) | 2021.08.01 |

|---|---|

| [3줄 RL] RL로 QP 풀기 (0) | 2021.07.30 |

| [3줄 RL] 큐러닝의 고질병을 해결하다 (1) | 2021.07.24 |

| [3줄 RL] 과학적 발견도 에이전트에게 맡겨둬! (0) | 2021.07.21 |

| [3줄 RL] 리워드 없이도 배운다 (1) | 2021.07.19 |