[3줄 RL] SMiRL: Surprise Minimizing Reinforcement Learning in Unstable Environme

2021. 7. 2. 15:33ㆍAI Paper Review/Deep RL Papers [EN]

<openreview> https://openreview.net/forum?id=cPZOyoDloxl

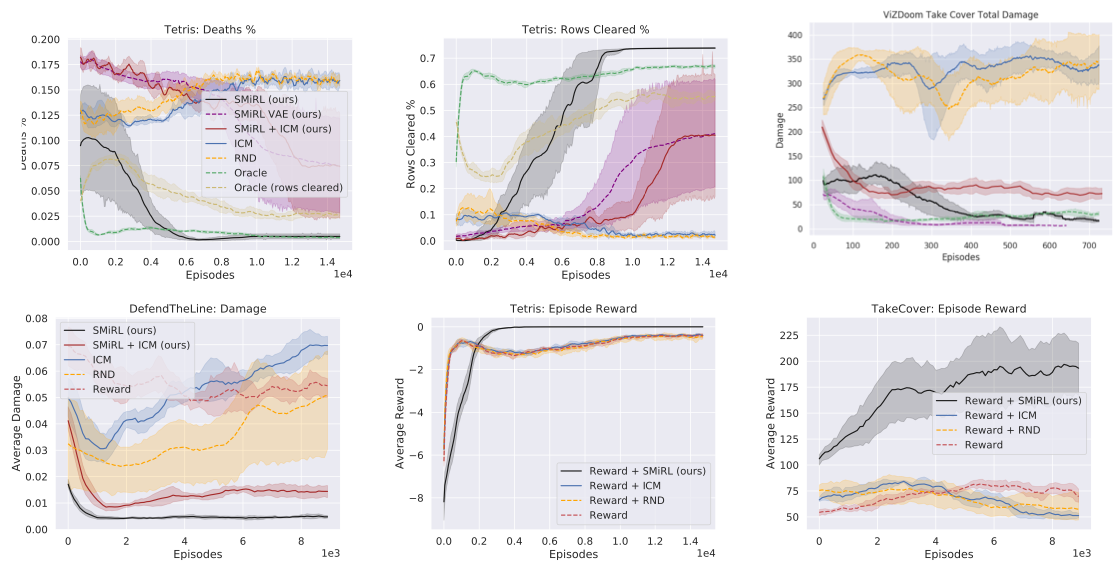

1. 강화학습을 이용해 문제를 풀 때 매우 불안정한 환경들에서는 엔트로피를 최대화하여 exploration을 최대화하는 것이 오히려 좋지 않은 것을 확인했고, 매우 불안정한 강화학습 환경에 대한 새로운 솔루션의 필요가 생기게 되었다.

2. 발상의 전환을 통해 오히려 엔트로피를 최소화, 행동의 novelty를 최소화해 exploration과 surprise를 오히려 감소 방법을 고안하여, 오히려 안정적인, "안전빵" 알고리즘을 만들고자 하였다.

3. 매우 불안정한 환경에서 SMiRL 프레임워크를 사용하였을 때 기존 알고리즘에 비해 좋은 성과를 내는 것을 관찰했는데, 필자가 생각하기에 이것은 너무 불안정한 상황에 놓여 있다면, 일단은 현실적으로 생각하는 것이 좋다는 철학에 기반한 성과가 아닐까 싶다.

'AI Paper Review > Deep RL Papers [EN]' 카테고리의 다른 글

| [3줄 RL] RL+Self-Supervised=Adaptation (2) | 2021.07.15 |

|---|---|

| [3줄 RL] 재무부 대신 에이전트 (0) | 2021.07.13 |

| WHAT MATTERS FOR ON-POLICY DEEP ACTOR-CRITIC METHODS? A LARGE-SCALE STUDY (0) | 2021.06.16 |

| Decision Transformer: Attention is all RL Need? (0) | 2021.06.12 |

| Evolving Reinforcement Learning Algorithms (0) | 2021.06.01 |